L’efficience est la qualité d’un rendement permettant de réaliser un objectif avec le minimum de moyens engagés. Il ne doit pas se confondre avec l’efficacité, qui ne mesure que l’atteinte d’un objectif sans précision des moyens utilisés. [Source : Wikipédia Fr]

L’efficience énergétique (on emploie très souvent, à tord, le terme d’efficacité énergétique) est un état de fonctionnement d’un système pour lequel la consommation d’énergie est minimisée pour un service rendu maximal. C’est un cas particulier de la notion d’efficience [Source : Wikipédia Fr].

L’efficience énergétique au sein des Datacentres

L’infrastructure (refroidissement, alimentation électrique, etc.) représente aujourd’hui souvent plus de la moitié de la consommation totale d’un datacentre.

L’amélioration de l’efficience énergétique d’un Datacentre consiste donc à réduire au maximum la consommation énergétique des infrastructures.

Pour évaluer cette efficience, le consortium Green Grid rassemble les principaux acteurs internationaux du secteur des technologies de l’information.

Son but est d’améliorer l’efficience énergétique des infrastructures informatiques. Il propose pour cela des outils et des recommandations sur le site TheGreenGrid.org.

GreenGrid a notamment proposé deux indicateurs : le PUE et le DCiE.

Attention, améliorer l’efficience énergétique du Datacentre peut, dans certains cas, se solder par une augmentation de la consommation énergétique globale du Datacentre (voir les limites des indicateurs PUE et DCiE), notamment lorsqu’on augmente la température d’exploitation d’un Datacentre non équipé en Free Cooling (voir notre synthèse de l’étude Intel : « Effet de la température sur l’efficience énergétique d’un Datacentre »).

Lors d’une démarche d’optimisation, il faudra donc prendre garde à contrôler l’ensemble des paramètres.

1. Réduire la consommation à la source

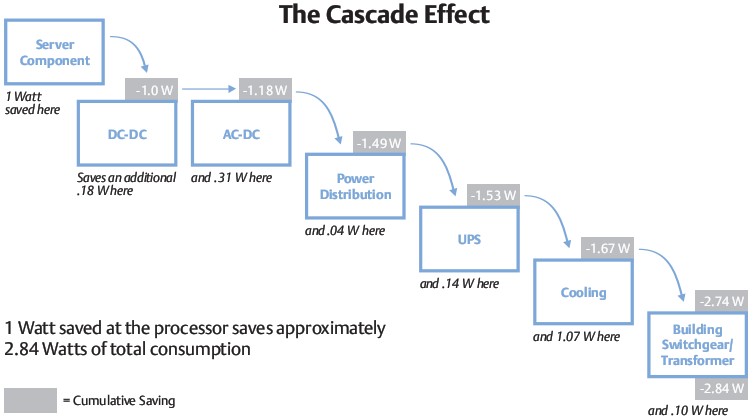

1 Watt économisé au niveau d’un serveur se traduit par 2,84 Watts économisés à l’échelle du centre de données [Source : Étude Emerson « Energy Logic: Reducing Data Center Energy Consumption by Creating Savings that Cascade Across Systems« ]. C’est ce que l’on appelle l’effet de cascade (voir le schéma ci-contre).

Agir sur l’existant

Mettre hors tension les serveurs inutiles : Selon une enquête de Kelton Research publiée le 16 octobre 2009, au moins 15% des serveurs allumés en Datacentre ne serviraient à rien.

La première étape consiste donc à identifier ces équipements et les éteindre.

Éteindre ou mettre en veille les serveurs inactifs : Cela peut par exemple être le cas des serveurs de calcul qui ne nécessitent pas d’être disponibles 24h/24 7j/7.

Virtualiser les serveurs (dans la mesure du possible) : La virtualisation permet de consolider au sein d’un même serveur physique, plusieurs serveurs virtualisés. Cela évite par exemple de maintenir des serveurs physiques allumés pour des services peu exploités mais que l’on doit malgré tout maintenir en ligne.

Installer le niveau de redondance [Définition Wikipédia de Redondance] matérielle approprié. En effet, lorsqu’on met en place un projet de consolidation de l’infrastructure, il faut considérer le besoin réel, afin d’investir au plus juste.

Acheter du matériel eco-labellisé : De nombreux écolabels existent pour le matériel informatique (80plus gold pour les alimentations, Energy Star permettent de sélectionner du matériel plus efficient (donc dégageant moins de chaleur). L’eco-label EPEAT permet de sélectionner le matériel sur ses performances énergétiques mais aussi sur ses performances environnementales.

Acheter du matériel avec des spécifications en température et taux d’humidité souples : Les conditions environnementales tolérées par le matériel (température, taux d’humidité, etc.) conditionnent directement les réglages du système de refroidissement et donc sa consommation d’énergie. L’idéal est d’acquérir de l’équipement respectant les recommandations de l’ASHRAE ou, mieux encore, celles de la norme ETSI EN 300 019-1-3.

Acheter des logiciels efficients : Intégrer le critère de la consommation des ressources dans le processus de sélection des logiciels.

2. Refroidir juste où il faut

Il existe, selon la taille et la génération du Datacentre, plusieurs systèmes de refroidissement, de la simple climatisation à air, aux baies réfrigérées par un circuit d’eau glacée.

Cependant, le système le plus répandu reste le refroidissement à air conditionné.

Il est possible d’améliorer significativement l’efficience d’un tel système avec relativement peu d’investissement en suivant deux objectifs :

Amener le froid au plus près des sources chaudes (c’est ce qui fait que le système à baies réfrigérées ou encore le système de Water Cooling [Refroidissement par eau (Wikipédia Water Cooling)] direct des composants soient si efficaces).

Séparer au maximum les flux d’air froid des flux d’air chaud afin d’éviter que l’air chaud ne vienne « polluer » l’air froid.

Pour atteindre ces objectifs, vous pouvez mettre en place les actions suivantes :

Implémenter le concept allées chaudes / allées froides : disposer les équipements IT dans les racks [Armoires de serveurs (Définition Wikipédia)] de manière à ce que leurs flux de refroidissement soient dans le même sens. Inverser le sens des flux, d’un rack à l’autre. Cela permet de rejeter l’air réchauffé par les équipements dans une allée sur deux, créant ainsi des allées froides. Voir le schéma ci-contre.

Isoler les allées froides des allées chaudes

- Boucher les emplacements de serveurs inoccupés au sein des racks par des panneaux prévus à cet effet.

- Installer des panneaux / cloisons au dessus des racks pour éviter au maximum le mélange de l’air froid de l’allée froide avec l’air chaud de l’allée chaude.

3. Refroidir juste ce qu’il faut

La question du réglage de la température est traitée plus en détail dans nos articles « Réglage de la climatisation » et « L’effet de la température sur l’efficience énergétique d’un Datacentre »

Mais d’une manière générale :

La température d’exploitation du Datacentre doit respecter les spécifications environnementales des équipements installés. Il est d’ailleurs recommandé d’organiser l’installation des équipements en fonction de celles-ci afin d’adapter au mieux le refroidissement.

L’association américaine des professionnels du conditionnement d’air (ASHRAE American Society of Heating, Refrigerating and Air-Conditioning Engineers) recommande une température comprise entre 18°C et 27°C (voir notre article « Présentation des normes environnementales de l’ASHRAE » pour plus de détails).

L’ETSI (European Telecommunications Standards Institute pour Institut européen des normes de télécommunication [article Wikipédia]) travaille sur la norme ETSI EN 300-019-1-3 qui recommande une température comprise entre 5°C et 40°C.

Une augmentation de température importante (30°C) du Datacentre ne se traduit pas forcément par une réduction de la consommation d’énergie globale (cf notre Guide de bonnes pratiques), sauf en cas de Free Cooling.

Les experts recommandent aujourd’hui une température aux alentours de 27°C (80°F) [Sources : DatacenterKnowledge – « Data Center Cooling Set Points Debated » ; GreenComputing – « Your Data Center is Much too Cold« ].

Pour aller plus loin

Nous vous avons présenté ici les recommandations les plus importantes pour améliorer l’efficience énergétique d’un centre de données. Pour aller plus loin dans cette démarche, vous pouvez consulter le Guide des bonnes pratiques du code de conduite européen sur les Datacentres.