Le calcul intensif à l’Université Joseph Fourier

L’université Joseph Fourier, à Grenoble, fourni à ses chercheurs des outils pour le calcul à haute performance (HPC) via le mésocentre de calcul CIMENT (Calcul Intensif Modélisation, Expérimentation Numérique et Technologique) et MaiMoSiNE (Maison de la Modélisation et de la Simulation, Nanosciences et Environnement)

Le calcul intensif nécessite de mettre en place des ordinateurs ultra puissants qui ont l’inconvénient de consommer beaucoup d’énergie et par conséquent de chauffer énormément. L’efficacité énergétique est donc un aspect important lors de l’achat d’une telle machine et ne concerne pas seulement l’efficacité de ses composants, mais aussi de celle des systèmes de refroidissement qui servent à évacuer la chaleur. CIMENT s’est engagé depuis plusieurs années à mettre en priorité haute les critères énergétiques dans les procédures d’achat et à essayer d’améliorer l’efficacité des datacentres dans lesquels sont implantés les supercalculateurs, afin de limiter le gaspillage énergétique.

La dernière acquisition de CIMENT-MaiMoSiNE est une plateforme de calcul complètement intégrée, comprenant de la puissance processeur (environ 3000 coeurs de calcul), des systèmes de stockage à haute performance, un réseau de calcul ultra-performant, un système de visualisation et un système de refroidissement innovant. D’une valeur totale de 1,6 millions d’euros, la plateforme Froggy réalise aujourd’hui des simulations scientifiques dans tous les domaines (physique, astronomie, biologie, géophysique, chimie,…) depuis plus d’un an.

Procédure d’achat

Le dossier

Pour cet achat, nous avions candidaté à un projet d’équipement d’excellence financé par le « grand emprunt ». Cela devait nous permettre d’acquérir une machine d’une taille plus conséquente que d’habitude, commune à toute l’université. Notre candidature portait le titre « Achat d’un supercalculateur éco-responsable ». Nous avions donc déjà mis l’accent sur le fait que nous voulions construire une machine qui soit innovante sur le plan énergétique et avions pris le pari que les constructeurs nous suivraient dans cette voie.

Le projet étant accepté, nous avons opté pour une procédure d’achat de type dialogue compétitif. C’est une procédure longue, qui a duré dans notre cas environ un an, mais qui a l’avantage de permettre l’évolution du cahier des charges au cours de nombreux échanges avec les différents fournisseurs qui ont candidaté à l’appel d’offre. Dans notre cas, c’était nécessaire car si nous avions de bonnes connaissances sur ce qui existait en terme de solutions technologiques pour le calcul intensif, nous étions beaucoup plus dans le flou pour ce qui concernait les solutions de refroidissement à haute efficacité énergétique.

En effet, ne disposant pas de datacentre pré-équipé pour accueillir une machine de cette taille, nous avons inclus dans le projet la partie que l’on appelle communément « fluides », c’est à dire la fourniture de l’énergie (construction de tableaux électriques) et du froid (installation des équipements nécessaires au refroidissement, à l’intérieur et à l’extérieur du batiment). Notre datacentre disposait cependant déjà de quelques baies refroidies par un système récent cloisonné en allée chaude, avec une circulation d’eau glacée. Nous verrons plus tard qu’une de ces baies a été mise à profit pour une partie de la solution.

La partie concernant le refroidissement a été distinguée dans le programme fonctionnel comme « prestation supplémentaire » afin de permettre aux fournisseurs de proposer une solution intégrée à la machine, mais aussi pour ne pas exclure les candidats qui ne seraient pas en mesure de faire ce type de prestation et d’éviter un marché infructueux. Cependant, les candidats étaient avisés que la fourniture de ce système dans le cadre de ce marché, avec une solution « innovante » serait un plus. En outre, dans les critères de notation, la valeur technique de la solution était fortement pondérée par l’efficacité sous la forme du rapport puissance crête totale/consommation électrique totale.

Green-500

Il existe un classement des 500 machines les plus puissantes du monde, le Top-500. Depuis quelques années, un autre classement met en valeur l’efficacité énergétique des machines de calcul, en distinguant les 500 machines les plus efficaces, c’est le Green-500.

Nous n’avions pas l’ambition de figurer dans l’un de ces classements, néanmoins, le Green-500 fourni un protocole de mesure standard qui nous a permis de demander aux constructeurs de réaliser un test normalisé sur la solution proposée afin de nous permettre de faire des comparaisons. Ce test, qui résulte en une mesure en Flops[[Flops: nombre d’opérations flotantes par secondes. C’est une mesure de puissance de calcul en informatique, traduisant la capacité d’un ordinateur à effectuer rapidement des opérations]]/watt était intégré à tous les autres tests (benchs) destinés à mesurer les performances de la machine. Nous avons également demandé aux fournisseurs de calculer une estimation de la consommation annuelle en KWh de la solution complète, système de refroidissement y compris, même dans le cas où ils ne proposeraient pas de solution optionnelle pour la fourniture du refroidissement (dans ce cas là, ils devaient se baser sur une estimation de la consommation de notre système actuel à eau glacée ou tout autre système qui serait préconisé)

Analyse des offres

Les candidats les plus sérieux ont tous proposé des solutions équivalentes en terme de performances pure. C’est assez logique, le marché étant dominé à cet instant par une gamme de processeurs assez réputés. Il y avait quelques différences au niveau de la topologie des réseaux de calcul; mais là où la différence se faisait le plus sentir, c’était justement sur les solutions de refroidissement des matériels proposés! Et nous avons au final opté pour une solution qui nous a semblé fort optimale car elle nous fournissait non seulement le réseau de calcul le plus performant, mais aussi une solution de refroidissement complètement intégrée et quasi révolutionnaire, offrant un PUE[[Le PUE est le rapport de l’énergie totale consommée incluant les systèmes de refroidissement sur l’énergie consommée par les équipements informatiques. On a généralement dans un datacentre d’ancienne génération un PUE autour de 2 et plutot autour de 1,4 pour les datacentres les plus modernes]] inférieur à 1,1 sur la partie noeuds de calcul! Le prestataire retenu – la société Bull – a fait une proposition incluant toutes les options demandés, en particulier la réalisation des travaux et la fourniture des matériels nécessaires au refroidissement de la machine.

Solution technique et réalisation

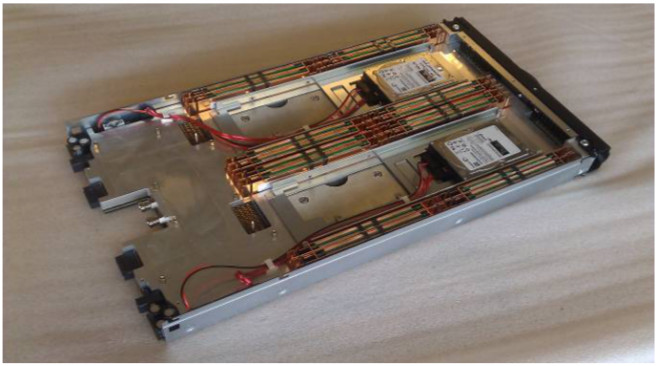

La solution technique repose sur des baies et des chassis complètement intégrés appellés DLC[[Direct Liquid Cooling: http://www.bull.com/bullx/bullxDLC.html]]. Les chassis comportent des lames de calcul et des commutateurs de réseau rapide (infiniband). Un circuit de refroidissement primaire fait circuler un liquide à l’intérieur de plaques en contact direct avec les composants (processeurs, mémoire, disques durs).

Chaque baie comporte un chassis hydraulique permettant d’échanger la chaleur avec un circuit de refroidissement secondaire dans lequel une eau circule à la température de 30 degrés maximum. C’est cette température d’eau assez élevée (eau tiède) qui permet au système d’être aussi efficace. En effet, produire de l’eau à cette température est assez simple puisqu’il suffit de faire circuler cette eau dans un échangeur eau/air situé à l’extérieur du bâtiment. Nul besoin de compresseur. Une simple pompe à eau et des ventilateurs suffisent à gérer l’échange. En cas de fortes chaleurs (plus de 30 degrés de température ambiante à l’extérieur, en général l’été en journée), de l’eau est brumisée sur un médium humide, provoquant ainsi un abaissement de la température par simple évaporation. Le système consomme donc un peu d’eau dans les périodes chaudes (30m3 durant l’été 2013 pour ce qui concerne Froggy).

Chaque baie comporte un chassis hydraulique permettant d’échanger la chaleur avec un circuit de refroidissement secondaire dans lequel une eau circule à la température de 30 degrés maximum. C’est cette température d’eau assez élevée (eau tiède) qui permet au système d’être aussi efficace. En effet, produire de l’eau à cette température est assez simple puisqu’il suffit de faire circuler cette eau dans un échangeur eau/air situé à l’extérieur du bâtiment. Nul besoin de compresseur. Une simple pompe à eau et des ventilateurs suffisent à gérer l’échange. En cas de fortes chaleurs (plus de 30 degrés de température ambiante à l’extérieur, en général l’été en journée), de l’eau est brumisée sur un médium humide, provoquant ainsi un abaissement de la température par simple évaporation. Le système consomme donc un peu d’eau dans les périodes chaudes (30m3 durant l’été 2013 pour ce qui concerne Froggy).

L’énergie consommée par le système de refroidissement (pompes + ventilateurs) représente moins de 10% de l’énergie consommée par les lames de calcul (soit un PUE inférieur à 1.1!).

L’énergie consommée par le système de refroidissement (pompes + ventilateurs) représente moins de 10% de l’énergie consommée par les lames de calcul (soit un PUE inférieur à 1.1!).

En outre, les lames de calcul sont alimentées par un réseau électrique en courant continu géré par des alimentations mutualisées dans les baies. Cela contribue également à limiter les pertes dûes à la conversion de l’énergie.

La réalisation du projet comprenait plusieurs phases: un chantier de plomberie, l’installation de la tour de refroidissement adiabatique à l’extérieur du bâtiment, la livraison des machines de calcul proprement dites, la livraison et le câblage des noeuds de service, la mise en route et un transfert de compétences ainsi qu’une formation utilisateurs. Le fait d’avoir un interlocuteur unique pour toutes les phases fut très confortable. Les délais ont tous été respectés, sauf pour la livraison de la tour de refroidissement. La machine ne pouvant fonctionner sans ce dispositif, la société Bull a d’abord effectué une mise en service dans son usine et nous a permis de commencer à exploiter la machine à distance avant son installation sur notre site.

Retour sur un an de production

Après aujourd’hui plus d’un an de production, nous pouvons dire que ce système est très satisfaisant. Le PUE annoncé est bien respecté sur la partie « noeuds de calcul ». La machine est relativement stable et la redondance des chassis hydraulique des baies fonctionne bien.

La consommation d’eau de l’évaporateur est très limitée. En effet, nous n’avons consommé que 30m3 d’eau entre mai 2013 et mai 2014. C’est moins que la consommation d’eau annuelle d’un ménage Français![[http://www.eaudegrenoble.fr/espacepublic/Aconsommermod%C3%A9r%C3%A9ment/Quelquesrep%C3%A8res.aspx :

« à Grenoble la consommation quotidienne d’eau par habitant est de 137 litres » soit 50m3 par an. Froggy est un nouvel habitant de l’agglomération économe en eau…]]

Pour ce qui est de l’investissement, dans le cadre de notre marché, il ne semble pas y avoir eu de sur-coût lié à cette technologie de refroidissement (en comparaison avec les autres offres). Notre circuit d’eau à eau tiède pourra être réutilisé pour d’autres systèmes qui seraient satisfait par ce régime.

Le seul bémol concerne l’impact d’un tel système « chaud » dans un datacentre classique. Puisque la masse métalique de la machine est maintenue à une température supérieure à 30 degrés, cela provoque un rayonnement chaud important qu’il vaut mieux avoir anticipé. C’est à dire qu’il faut prévoir que la machine soit installée dans une zone cloisonnée où aucun système de climatisation ne cherchera à faire baisser la température ambiante à moins de 30 degrés! Dans notre cas, nous avons dû construire un cloisonnement (placo+isolant) autour des baies afin de limiter l’impact sur nos autres systèmes en allée chaude qui sur-consommaient inutilement, en raison de la proximité dans le même datacentre.

Autre détail gênant, les alimentations électriques mutualisées, installées dans les baies DLC, ne sont pas refroidies par eau. Elles nécessitent donc un petit apport d’air froid que nous avons prélevé sur notre système à eau glacée par l’intermédiaire de petits échangeurs. Cela diminue l’efficacité globale de la solution. La société Bull travaille actuellement sur une nouvelle version du système DLC qui intégrerait peut-être les alimentations dans le refroidissement à eau tiède.